Google saust stetig durchs Netz, um Webseiten zu crawlen (= zu erfassen). Dabei beachtet der Suchmaschinenriese nicht alle Seiten ähnlich aufmerksam. Hier lest ihr, was das für euch als Website-Betreiber bedeutet.

|

| (Search Engine Optimization unter CC0 1.0) |

Googlebot heißt das Programm, mit dem Google Webseiten crawlt. „Bot“ ist dabei die Kurzform für „Robot“. Drei Schritte sind nötig, bis eine Webseite in den Google-Trefferlisten erscheint:

- Crawling: Der Googlebot erfasst die Seiten (engl. to crawl = kriechen, krabbeln [über eine Webseite]).

- Indexierung: Google nimmt die Seiten in seinen Bestand auf.

- Ranking: Google bringt die Seiten in den Trefferlisten algorithmisch in eine Reihenfolge.

Heißt: Das Crawling eurer Seiten ist die Grundvoraussetzung dafür, dass sie überhaupt bei Google auffindbar sind. Das Crawl-Budget definiert dabei, wie viele eurer URLs der Googlebot crawlen kann und will. Es berechnet sich aus der Crawl-Rate und dem Crawl-Bedarf.

So berechnet Google die Crawl-Rate

Google möchte mit seinen Crawling-Aktivitäten haushalten und sich dabei auf wichtige und hochwertige Inhalte konzentrieren. Deshalb arbeitet es mit einer sogenannten Crawl-Rate. Sie beschäftigt sich mit den folgenden technischen Fragen:

➧ Wie viele parallele Verbindungen soll der Googlebot maximal verwenden, um eine Webseite zu crawlen?

➧ Und wie viel Zeit soll zwischen den Abrufen vergehen?

Die Begrenzung dieser Crawl-Rate (= Crawl-Rate-Limit) kann schwanken: Reagiert eure Website schnell, erweitert sich das Limit. Der Googlebot kann mehr Verbindungen nutzen, um sie zu crawlen. Reagiert eure Site langsam oder mit Server-Fehlern, beschränkt sich das Limit und der Googlebot crawlt weniger und seltener.

So stuft Google den Crawl-Bedarf eurer Website ein

➧ Popularität: Je beliebter eine URL (= Web-Adresse) bei den Usern ist, desto öfter wird Google sie crawlen, um die jeweils „frischeste“ Version zu indexieren.

➧ Veraltete Inhalte: Google möchte keine überholten Inhalte in seinem Index haben. Entsprechend wenig beachtet es solche Seiten beim Crawlen.

➧ Auch größere Ereignisse wie Website-Umzüge können den Crawl-Bedarf erhöhen, da Google die bekannten Inhalte unter den neu entstandenen URLs re-indexieren will.

|

| Der Googlebot saust durchs Web (CC0 1.0) |

Rate + Bedarf = Budget

Das Crawl-Budget definiert, wie viele eurer URLs der Googlebot crawlen kann (Crawl-Rate) und crawlen will (Crawl-Bedarf).

Heißt in der Praxis: Je weniger hochwertige Webseiten euer Online-Auftritt bietet und je langsamer diese laden, desto unmotivierter wird der Googlebot sein, sie zu crawlen.

Was heißt das für eure Website?

Euer Online-Auftritt hat keine Tausende Seiten? Dann könnt ihr laut Google dem Thema Crawl-Budget gelassen begegnen: Eure Seiten sollten problemlos und effizient gecrawlt werden. Sollte euer Web-Auftritt jedoch deutlich größer ein, solltet ihr das Thema Crawl-Budget stärker beachten.

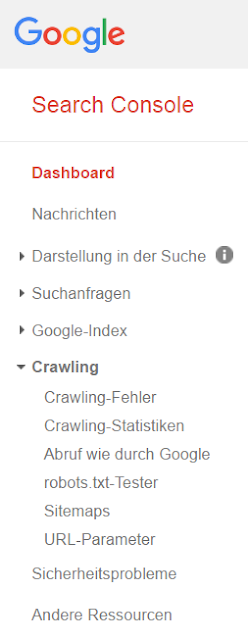

Egal wie groß oder klein eure Website ist, ihr solltet in jedem Fall regelmäßig die Crawling-Infos in der Google Search Console checken:

Zusätzliche Tipps:

➧ Mittels robots.txt könnt ihr das Crawl-Budget beeinflussen.

➧ Eine XML-Sitemap erleichtert es dem Googlebot, eure Seiten zu crawlen.

➧ Je schneller die Ladezeiten eurer Website, desto freudiger wird der Googlebot sie crawlen.

Quelle & Link-Tipp:

- Google Webmaster Central Blog: What Crawl Budget Means for Googlebot