Harter Fakt für viele kleine Unternehmen: A/B-Tests im Online-Marketing sind oft nicht aussagekräftig, weil die Datenmenge zu gering ist. Um statistische Signifikanz zu erreichen, braucht es in der Praxis mehrere hundert relevante Ereignisse pro Variante (etwa Klicks oder Conversions). Doch es gibt alternative Optimierungsmethoden für Landingpages, Newsletter & Co. Hier kommen die Details.

Der erste Teil meiner Marketing-Analytics-Blogserie lautete „Warum A/B-Testing in der Praxis oft eine statistische Luftnummer ist“ (Link am Beitragsende). Er blickte auf folgende Punkte:

- Was ist A/B-Testing?

- Wie wird A/B-Testing durchgeführt?

- Statistische Signifikanz einfach erklärt

- Woran A/B-Testing in der Praxis statistisch scheitert

Dieser zweite Teil fokussiert nun folgende Punkte:

- Recap: Warum A/B-Testing im Online-Marketing oft unbrauchbar ist

- Zu wenig Daten für statistische Signifikanz: Alternativen zum A/B-Test

- Qualitative UX-Methoden statt A/B-Tests: ein Beispiel

Vorhang auf.

Recap: Warum A/B-Testing im Online-Marketing oft unbrauchbar ist

A/B-Testing benötigt ausreichend Daten, um statistisch aussagekräftig zu sein. Genau daran scheitert es in vielen Unternehmen. Ob Website, Landingpage, Newsletter oder Social-Media-Kampagne: Pro Variante braucht es mehrere hundert Ereignisse (z. B. Klicks oder Conversions). Werden diese nicht erreicht, sind die Resultate eines A/B-Tests statistisch praktisch wertlos.

Die ausführliche Erklärung findet ihr im unten verlinkten Beitrag „Marketing-Analytics (Teil 1): Warum A/B-Tests oft eine statistische Luftnummer sind“.

Für die Online-Marketing-Praxis bleibt die Frage: Können kleine Unternehmen dann überhaupt ihre Online-Marketing-Maßnahmen datenbasiert optimieren? Die kurze Antwort lautet: Ja. Aber mit anderen Methoden.

Zu wenig Daten für statistische Signifikanz: Alternativen zum A/B-Test

Qualitative UX-Methoden sind eine Alternative zu A/B-Tests, wenn die Datenmenge nicht ausreicht. UX steht für User Experience (Nutzer*innen-Erlebnis). Einige Beispiele für solche Methoden:

| Qualitative UX-Methode | Beschreibung |

|---|---|

| Heatmaps | „Wärmekamerabilder“ zeigen, wo auf Landingpages oder in Newslettern geklickt bzw. gescrollt wird. |

| Session Recordings | User-Verhalten wird aufgezeichnet, um Abbruchstellen nachvollziehen zu können. |

| Usability-Tests (z. B. über Fragebögen) | Bereits 5 User*innen finden ca. 85 % der Usability-Probleme (nicht Conversion-Probleme!). |

Kombiniert ihr diese Methoden mit Vorher-/Nachher-Tests (Pre-/Post-Tests), ersetzt ihr zwar keinen A/B-Test, aber: Ihr bekommt auch bei wenig Daten einen brauchbaren Optimierungshebel für eure Online-Marketing-Kampagnen.

Schauen wir uns das an einem Beispiel an:

Qualitative UX-Methoden statt A/B-Tests: ein Beispiel

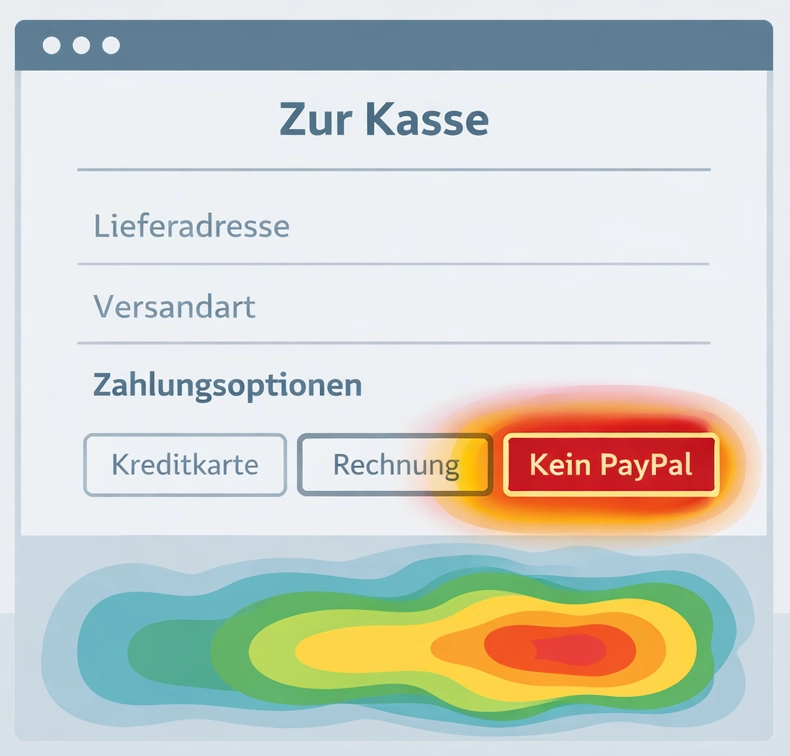

In einem Online-Shop ist die Warenkorb-Abbruchrate hoch: Viele Nutzer*innen gehen zur Kasse, schließen den Kauf aber nicht ab. Eine Heatmap zeigt verstärkte Aktivität im Bereich der Bezahloptionen. Es fehlt eine PayPal-Zahloption.

Hypothese: Das Hinzufügen einer PayPal-Zahloption senkt die Warenkorb-Abbruchquote. Um diese Annahme zu prüfen, wird PayPal integriert und die Abbruchrate vor und nach der Änderung verglichen (Pre-/Post-Test).

So können Online-Marketing-Kampagnen auch bei überschaubarer Datenmenge effektiv optimiert werden. Aber: Diese Methode „Qualitative UX-Methode & Vorher-/Nachher-Test“ ist gegenüber einem statistisch validen A/B-Test eingeschränkt. Drei Gründe:

Erstens fehlt eine echte Kontrollgruppe (die Original-Variante A im A/B-Test). Es ist nicht eindeutig feststellbar, wie sich die Abbruchrate ohne die Änderung entwickelt hätte, weil der Ursprungszustand (= PayPal-Zahloption fehlt) nicht parallel weiterläuft.

Zweitens wird die Hypothese nicht parallel, sondern zeitversetzt überprüft (Vorher/Nachher statt A+B parallel). Dadurch können Tageseffekte (z. B. Feiertage), Kampagnen oder externe Einflussfaktoren (z. B. Gehaltszahlungen, Wetter) die Warenkorb-Ergebnisse verzerren.

Drittens bleibt die Datenmenge auch bei dieser Vorgehensweise begrenzt. Längere Beobachtungszeiträume können das abmildern, verstärken aber zugleich die zeitliche Verzerrung.

Qualitativer UX-Test & Vorher-/Nachher-Test: Eine praktikable Methode für kleine Unternehmen

Bei allen genannten Schwächen: Statt auf statistisch unbrauchbare A/B-Tests zu setzen, sind kleine Unternehmen mit dem Ansatz „Qualitativer UX-Test und Vorher-/Nachher-Test“ besser bedient. Wer hier konsequent dranbleibt, kann Online-Marketing-Kampagnen gezielt verbessern.

Vorsicht ist geboten bei Tools, die euch A/B-Testing-Funktionen bieten, ohne auf die statistische Schwäche bei zu geringer Datenmenge hinzuweisen. Die rein funktionale Möglichkeit, einen A/B-Test zu fahren, macht diesen nicht automatisch statistisch brauchbar. Seriöse Tools geben euch das Feedback, dass die Datenmenge nicht ausreichend für statistische Signifikanz ist.

Deshalb mein Tipp: Reicht eure Datenmenge nicht, dann setzt auf qualitative UX-Test, kombiniert mit Pre-/Post-Tests.

Ich wünsche euch viel Erfolg bei eurer Conversion-Rate-Optimierung.

Link-Tipps hier auf meinem Blog „Der Onliner – Marketing & Wirtschaft 4.0“:

Marketing-Analytics (Teil 1): Warum A/B-Tests oft eine statistische Luftnummer sind

Externe Link-Tipps:

vwo.com: Wie man Heatmaps für ein besseres User-Erlebnis einsetzt

microsoft.com: Das kostenlose UX-Testing-Tool Clarity